AI 对话集:因果推理和大语言模型

[2023-10-28 Sat 21:11] 添加对论文 Can Large Language Models Infer Causation from Correlation? 的理解

围绕因果推理和大语言模型相关论文、文章的理解和对话。

Causal Reasoning and Large Language Models: Opening a New Frontier for Causality

本章是对 (Kıcıman et al., 2023) 的理解,该论文将因果相关的问题转换成自然语言描述后向 chatgpt/gpt4 提问,在多种不同的因果推理数据集上测试,发现各个任务的结果相比当前最好的算法都有近两位数百分点的提升,这在数值上是比较令人惊讶的。

论文比较长,但实验方法非常简单,是一种 prompt 工程在因果任务上的应用,如果能够访问 chatgpt 或者同类的大语言模型,可以一边阅读一边复现论文里提到的例子,所以在实践上并没有太多可以学习的,本文的核心还是学习因果科学里的基本概念以及 LLM 出现后对解决这些问题而产生的新视角。

论文第一章相当于是全文的一个概括,如果不理解具体任务和问题,不太容易理解,因此直接进入第二章

2 Background and Preliminaries

本章介绍了对因果关系的三种分类方法,对于因果关系这种看似简单却又很微妙的概念,在理解其分类法前,先用一个简单的例子说明"分类"。

当我们看待人类的时候,可以有 N 种视角:

- 肤色角度:分成黑,白,黄等

- 社会阶层角度:无产阶级,资产阶级等

- 性别:男女

- 其他视角:职业,文化,语言,国家,血型等等

每一次好的分类的发明都是创造了新的看问题的视角和知识,分类会直接导致新概念的产生,如果在已经有许多分类的领域再做一次分类,会产生大量交叉的概念。比如根据 Circle Division by Lines – from Wolfram MathWorld, 如果当前已经对某个圆划分了 n-1 次,那么你再给这个圆切分一次,最多会产生 n 个新的区域。这还只是平面切分, 如果是如论文里 "Here we describe three orthogonal categories of causal approaches and tasks" 里提到的正交分类法,意味着第 n 次划分为得到 \( 2^n \) 个子概念,何况很多时候一次不是进行二分,而是 k 分。

论文针对因果关系的划分是:

- 从方法上来区分,有 covariance-based 和 logical-based 两种研究因果关系的典型方法,也就是基于统计和逻辑逻辑的区别。

- 按抽象程度来区分,有 type 和 actual causality 两种,翻译成类型因果和实际因果。 可以用面向对象中的类和实例来理解。

- 从目的或者任务层面来区分,也就是说,关于因果有哪些值得探究的问题:

- 因果发现:没有给定的事件,只有一段文本(比如病例),从中发掘出可能具有因果关系的疾病和症状

- 因果估计:知道了因果关系和方向的情况下继续量化原因对结果的影响。

- attribution:给定一个结果,确定原因(这与因果发现有什么区别?侧重点不同?)

由于这些划分是垂直的("orthogonal"),所以理论上不同区分里的类别可以混合在一起组成一个新概念,比如: covariance-based causal discovery 是 convariance-based 方法与因果发掘任务的组合,同样可能还有基于逻辑的实际因果分类,基于协方差的类型因果挖掘等。

covariance- vs. logical- 方法的对话

covariance-based causal discovery 是怎么做的,能否用一个简单的例子来说明,它和 logical base 的因果发现方法有什么区别,同样举一个例子进行对比,为什么要区分这两种方法呢?

协方差基础的因果发现(Covariance-based causal discovery)是一种统计方法,用于从观察数据中发现因果关系。这种方法的基本思想是,如果两个变量之间存在因果关系,那么它们应该是协方差不为零的。换句话说,如果改变一个变量会导致另一个变量的变化,那么这两个变量之间就可能存在因果关系。

例如,假设我们有一个数据集,其中包含了学生的学习时间(X)和他们的考试成绩(Y)。我们可以计算X和Y的协方差,如果协方差不为零,那么我们就可以推断学习时间可能会影响考试成绩。

X Y

2.2 3.4

3.4 4.5

4.6 5.5

5.5 6.7

6.7 7.5

然而,协方差基础的因果发现方法有一个重要的局限性,那就是它不能区分因果关系的方向。在上述例子中,我们无法确定是学习时间影响了考试成绩,还是考试成绩影响了学习时间。

逻辑基础的因果发现(Logical-based causal discovery)方法则是基于逻辑推理的。这种方法通常需要一些先验知识,例如因果图或因果模型。然后,通过逻辑推理,我们可以确定因果关系的方向。

例如,假设我们有一个因果图,其中包含了"吸烟"(X)和"肺癌"(Y)。根据这个因果图,我们可以推断出吸烟会增加患肺癌的风险,而不是肺癌导致了吸烟。

这两种方法的主要区别在于,协方差基础的方法主要依赖于统计分析,而逻辑基础的方法则依赖于逻辑推理。因此,它们在处理不同类型的问题时各有优势。例如,当我们有大量的观察数据,但缺乏先验知识时,协方差基础的方法可能更有用。而当我们有明确的先验知识,但缺乏足够的数据时,逻辑基础的方法可能更有优势。

以上回答中 "如果改变一个变量会导致另一个变量的变化,那么这两个变量之间就可能存在因果关系" 虽然用到了 "可能" 一词,但这段回答还是容易产生误导,因为协方差的值不单不能区分因果关系的方向,也不能确认是否有因果,只体现了相关性。于是继续追问

Covariance-based causal discovery 似乎只能发现相关性,为什么叫因果发现?应该要结合别的先验知识或者工具吧,如果有的话,请举例说明

你的理解是正确的。协方差基础的因果发现方法主要是通过观察两个或多个变量之间的协方差(即它们同时变化的程度)来寻找可能的因果关系。然而,这种方法只能发现变量之间的相关性,而不能确定因果关系的方向,也就是说,它不能确定是A导致了B,还是B导致了A,或者是存在第三个变量C导致了A和B同时变化。

为了确定因果关系的方向,我们通常需要结合其他的方法或工具,例如因果图(Causal Graphs)或者因果模型(Causal Models)。这些工具通常需要一些先验知识,例如已知的因果关系或者领域专家的知识。

例如,假设我们观察到吸烟(X)和肺癌(Y)之间存在协方差,即吸烟者中肺癌的发病率较高。然而,我们不能仅仅根据这个观察结果就确定吸烟导致了肺癌,因为可能存在其他的解释,例如吸烟者可能更可能接触到其他的致癌物质。为了确定吸烟是否真的导致了肺癌,我们需要结合先验知识(例如医学研究结果)或者进行更深入的研究(例如随机对照试验)。

总的来说,协方差基础的因果发现方法是一种有用的工具,可以帮助我们发现可能的因果关系,但要确定因果关系的方向,通常需要结合其他的方法和工具。

以上回答还是有比较多问题,比如"存在协方差" 这种说法,但总的来说这体现了 Covariance-based causal discovery 和 logical base 的方法经常要结合在一起,或者需要一些先验的东西来引导 Covariance-based 方法。

一种比较广泛使用的 covariance-based 因果发现算法是 PC 算法, 参考:10.4 - The PC Algorithm for Causal Discovery_哔哩哔哩_bilibili

type vs. actual causality 对话

因果关系根据抽象层划分为 type causality 和 actual causality. 是否可以用面向对象中的类和实例来理解这种划分,比如 type causality 是作为一种类似自然规律的因果(为什么出太阳会导致气温升高,这里需要回答的是一个科学问题)和个人遭遇(为什么昨晚粗心导致把个人信息群发了,这里涉及的问题更类似侦查破案,因此法律领域很关注)的因果。 这些划分的意义是什么?这两种因果区分真的很大吗?

在哲学和科学中,因果关系是一个复杂且深入的主题。你提到的"type causality"和"actual causality",也就是类型因果和实际因果,是因果关系的两种不同的理论解释。这两种因果关系的区别主要在于它们的抽象程度和应用领域。

类型因果(Type Causality)通常被理解为一种普遍性的、抽象的因果关系,它描述的是一种类别或类型的事件之间的因果关系,而不是具体的、个别的事件。比如,你提到的"出太阳会导致气温升高",这是一种普遍的自然规律,可以被看作是类型因果。这种因果关系通常在科学研究中被广泛使用,用于描述和解释自然现象和规律。

实际因果(Actual Causality)则是指具体的、个别的事件之间的因果关系。比如,你提到的"昨晚粗心导致把个人信息群发了",这是一个具体的事件,涉及到的是个别的因果关系,可以被看作是实际因果。这种因果关系通常在法律、历史、日常生活等领域中被广泛使用,用于解释和理解具体的事件和行为。

你的比喻是有道理的,可以将类型因果看作是面向对象编程中的"类",而实际因果看作是"实例"。"类"定义了一种类型的属性和行为,而"实例"则是这种类型的具体表现。同样,类型因果定义了一种类型的事件之间的因果关系,而实际因果则是这种因果关系的具体表现。

这种划分的意义在于,它可以帮助我们更好地理解和分析因果关系。类型因果和实际因果虽然都是描述因果关系的,但它们的应用领域和研究方法是不同的。类型因果更关注普遍的规律和原理,而实际因果更关注具体的事件和情境。这种区分可以帮助我们更好地理解和分析不同的问题和现象。

至于这两种因果关系的区别是否很大,这取决于你从哪个角度看。从抽象程度和应用领域来看,它们的区别是很大的。但从本质上来看,它们都是描述因果关系的,只是描述的对象和方法不同而已。

type causaliy 是否是科学野心驱动的,似乎来自于对"本质"的执念,因为一旦掌握了某种世界运行的因果规律,就可以预测任何进入这个规律中的个体的行为,例如一个人吸烟了,由于我有了"吸烟有害健康" 这个"因果定理", 就可以断定此人的健康会受到损害。

你的理解是正确的。类型因果(Type Causality)确实是由科学的探索精神驱动的,它试图揭示世界的普遍规律和原理。这种因果关系的理解有助于我们预测和解释自然现象,以及制定有效的政策和决策。

例如,你提到的"吸烟有害健康"就是一个类型因果的例子。这是一个广泛接受的医学原理,它告诉我们吸烟(原因)会导致健康问题(结果)。这个原理是基于大量的科学研究和统计数据得出的,它适用于所有的吸烟者,而不仅仅是某一个具体的个体。

这种对"本质"的追求,对普遍规律的探索,是科学的核心驱动力。通过理解这些规律,我们可以预测和控制自然现象,提高我们的生活质量,甚至解决一些重大的社会问题。这也是为什么科学家们会花费大量的时间和精力去研究和验证这些类型因果关系的原因。

Actual Causality (The MIT Press): Halpern, Joseph Y. 的第一章,对 type causality 和 actual causality 有许多描述,比如说到统计学家更多关注于 type causality, 而他们寻找的是 effects of causes. 而大部分学习模型都是对实际因果的发掘,也就是寻找 causes of effects, 因为训练出一个模型更多是在对个体示例的预测.

这里就继续追问:

effects of causes 和 causes of effects 有什么区别? 为什么统计学家更多关注 type causality, 而这种因果对应的是确定 effects of causes, 相对应的,机器学习里更多是对实际因果的发掘,也就是寻找 causes of effects

"Effects of causes"和"causes of effects"是两种不同的因果关系分析方法,它们的主要区别在于分析的方向和目标。

Effects of Causes

这种方法主要关注的是已知原因可能产生的效果。例如,我们知道吸烟(原因)可能会导致肺癌(效果)。在这种情况下,我们的目标是确定一个已知的原因可能会产生什么样的效果。

Causes of Effects

这种方法主要关注的是已知效果可能的原因。例如,我们知道一个人得了肺癌(效果),我们的目标是找出可能导致这个效果的原因(比如吸烟、空气污染等)。

统计学家通常更关注"effects of causes",也就是类型因果(Type Causality),因为他们的目标通常是确定和验证一种普遍的因果关系或规律。例如,他们可能想要确定吸烟是否会增加得肺癌的风险,或者教育水平是否会影响个人的收入水平。这种方法通常需要大量的数据和复杂的统计分析。

相比之下,机器学习通常更关注"causes of effects",也就是实际因果(Actual Causality),因为他们的目标通常是预测和解释具体的事件或现象。例如,他们可能想要预测一个人是否会得肺癌,或者解释为什么一个人的收入水平比其他人高。这种方法通常需要复杂的算法和模型。

这两种方法的区别主要在于它们的分析方向和目标,但它们都是为了更好地理解和分析因果关系。不同的问题和场景可能需要不同的方法,因此,理解这两种方法的区别和适用性是非常重要的。

从这个回答可以看出,尽管作者说 type vs. actual 和 covariance- vs. logical- 是两种正交的划分,但实际上 type causality 更加倾向于 covariance 方法, 不是完全"正交",

针对 type 和 actual 的朴素思考

可以这么理解,对于 type causality, 一般来说支撑的数据会更多,比如对于某个疾病的认识可以基于大量病例的分析,因此偏统计方法,而对于 actual causality, 由于是针对个体事件探索因果,比如根据某个人的症状来判断病因,个人的数据相对很少,需要更多先验知识(这些知识很多是 type causality 研究得到的基本规律或尝试)。

还是以医生看病的例子来梳理实际因果里的推理问题,这有助于理解一般人是如何思考因果的:

- 当医生看到某患者的症状后:

如果症状比较典型(typical),同时患者自己清晰地描述了关于症状的背景,比如被刀割破后没有及时清洗导致感染,那么医生可以直接依靠自己经验模型去找到"典型症状" 的 "典型处理方案", 这里的"典型" 就对应了 type. 比如外敷/内服消炎药等,这里面实际没有统计方法,基本是一个从"个例" 到 "类" 的识别,然后根据之前医学探索积累的"逻辑知识", 例如因为乙酰氨基酚可以抗炎(这是因果关系),于是采用了某种治疗方法。

去地方小诊所看常见病就是这种流程

- 如果医生无法高概率判断出症状对应的 "类", 那么需要用更多检查方法,比如化验等,这个过程可以认为是一种特征工程,目的是为了识别出"类", 就像从图片识别出这个是"鸟","狗" 一样。有了症状对应的类,就可以根据类级别的医学知识来做推理。

- 如果是以前没有遇到过的症状,比如 2020 年的新冠,则一方面需要去分析病毒序列,在病毒"本质"分解层面做逻辑推理,比如找出某些 DNA/RAN 与现有的已经研究过的病毒的 DNA/RNA 片段的相似性后根据现有认识做推理;另一方面要临床治疗的统计数据去分析。后者基本就是一个 covariance-based type causality discovery 任务。

总结来看,对于实际因果的发掘,可能更多是通过个体的数据来找到其中最核心的几个 type 是什么,然后借助逻辑方法来获得因果认识

以上对 type 和 causality 的分析有哪些问题

你的分析非常深入,对于因果推理在医学领域的应用进行了详细的阐述。你正确地指出了在处理具体的医疗问题时,医生会根据症状和经验来确定疾病的类型(type),然后根据这个类型来选择相应的治疗方案。这是一个典型的因果推理过程。

你也正确地指出了在处理新出现的、未知的疾病(如新冠病毒)时,医生和科学家需要进行更深入的研究,包括病毒序列的分析和临床统计数据的分析,这些都是寻找因果关系的过程。

你的分析中,我觉得有一点可以进一步讨论。你提到了"个体的数据"和"最核心的几个类型",这是非常重要的观点。在实际的因果推理过程中,我们确实需要从个体的数据中找出关键的类型,然后根据这些类型来进行因果推理。但是,这个过程可能并不总是那么直接或者明显。有时候,我们可能需要通过复杂的统计分析,甚至机器学习算法,来从大量的个体数据中找出关键的类型。这是一个既复杂又有挑战性的过程,但也是非常重要的。

总的来说,你的分析非常深入,对于因果推理的理解非常到位。

这个回答更多是迎合用户了😥。

本节只是自己对于这两个类别的因果的朴素的理解,阅读第三章和第四章实验后,会对两种因果的区分有更清晰的理解。

2.2 Different Causal Tasks and their Connection to Kinds of Causality

本节介绍与因果关系有关的不同任务,这些任务会在后文详细讨论

- 因果发现 causal discovery: 它用于发掘某个系统内变量之间的因果关系,通常最终以因果图的形式来表示 大部分属于 covariance-based in the context of type causality. 也就是因果发现大部分还是基于统计方法的,并且是对 type causality 的发现。

- 效应推理 effect inference: 在已经有因果关系(图)的基础上定量分析,更多是属于 type causality ,但也有个体的效应分析

- 归因 attribution, 判断某个结果或结果变化的原因,在 type 或 actual 因果中都有, "they usually incorporate additional considertions of morality, normality, and intent of agents"

- judgment and other tasks;

2.4 Probing LLM behaviors

本节可以认为是对论文结论有效性的辩护,因为 LLM 是一个黑盒模型,并且看过大量数据,如何能够确保模型的结论是因为 LLM 背诵了结果还是通过大模型涌现出的推理能力而推导出的?这些问题实际本文没有很好地回答,但至少有一定的解释力。 包括以下三类测评:

- benchmark test 和 QA 这个是论文公布的 SOTA 结论的来源

- memorization test 检查模型在训练的时候是否见过 benchmark 里测试集的答案,比如给定某个数据集的描述,先让模型 "背诵数据集全文", 然后检查背诵结果。

Redaction Test: 通过随机删除输入句子里的词并观察结果的好坏来分析输入中不同词汇的重要度

We probe the importance of individual words for getting a correct answer by redacting a random word from a question 这个什么意思, redacting 实验如何设计

这句话的意思是,我们通过随机删除一个问题中的单词来探究对于得出正确答案,每个单词的重要性。 Redacting在这里指的是删除或隐藏单词。为了进行这个实验,我们可以使用纯文本编辑器或编程语言中的字符串替换方法,例如Python的字符串方法replace(),将一个问题中的一个单词随机替换为某个特殊字符或空字符。然后,我们可以使用经过训练的LLM对修改后的问题进行预测,记录LLM在不同单词被删除的情况下的准确度,以此来评估每个单词对问题回答的重要性。

这些实验会在后文里详细提到。

3 LLMs and Causal Discovery

本章介绍在因果发现任务/数据集上的实验,传统因果发现的输入是某些变量以及数据(典型的统计学里的表格数据),输出的是这些变量组成的一张有向图,图中 A->B 表示的是变量 A 对 B 有因果效应。

可以拆分成更小的子任务:

- 给定两个事件(变量),判断因果方向,可以假定变量之间一定有因果关系,因此被视为二分类(3.1 节)

- 给定两个事件(变量),判断因果方向以及是否有因果关系,因此被视为三分类(3.2 节)

3.1 Pairwise causal discovery

你了解 Tübingen cause-effect pairs dataset 这个数据集吗

是的,Tübingen cause-effect pairs 数据集是一个用于研究因果推断的公共数据集。它包括了超过 6,500 个因果关系对,每个因果关系对包括一个影响因素和一个受影响的因素,而且这些因素都是以自然语言的形式描述的。该数据集收集了来自不同领域(如物理、医学、社会学以及语言学)的论文中的因果关系,并经过了严格的筛选和分类。 该数据集的目的是提供一个广泛覆盖不同领域和复杂性水平的因果关系,以便研究因果推断算法的表现和比较。这些因果关系对不仅被用于基于规则或机器学习算法的因果推断模型的评估,还被用于研究大脑如何推断因果关系。

我不知道这个回答是对是错,因此还是找到这个数据集的几个样例了解一番再提问:

我在这个数据集中找到了一个如下所示的数据

Name Data Type Meas. Description

-— ----–— –— ------–—

x: Rings integer +1.5 gives the age in years

y: Diameter continuous mm perpendicular to length

Ground truth:

x –> y

请问这是什么意思

这个数据表示有两个变量,分别是“Rings”和“Diameter”。其中,“Rings”是一个整数类型的变量,它们的单位是“年”,但需要加上1.5才能获得年龄(也就是说1.5表示出生时的状态),“Diameter”是一个连续型变量,单位是“毫米”,表示这个对象垂直于长度的直径。 然后,"Ground truth: x–>y"表示通过给定的数据集进行推断,已经确认了“x”对“y”的因果关系,“–>”箭头指向“y”,即表示“x”是“y”的因果影响因素。在这个数据集中,“x”的具体含义是“年龄”,“y”的具体含义是“直径”。因此,可以得出的结论是,年龄的变化可以导致直径的变化。

以上解释非常好,让自己很快就理解了 Tübingen cause-effect 数据集的格式和任务。

从这里可以推测,传统的 covariance-based approaches 因果发现就是根据变量对的采样数据(比如采集了 100 棵树木的年轮数量和树干直径)做统计分析来推断因果方向。

而 LLM 基于知识的因果发现则接近普通人的思维,把关于变量的描述(metadata)整理成文字直接询问 chatgpt, 比如先给 GPT 解释什么是年轮以及树干直径(或者不用解释,GPT 的参数里已经编码了这些概念),然后问是年轮数量影响了树干直径,还是树干直径影响年轮数量。

关于两种方法的对比,论文里的原话是:

In contrast to causal discovery algorithms that use data values of variables, LLMs can infer causal structure by reasoning on metadata associated with the variables, for example, the name of the variable and the problem context expressed in natural language. we call the LLMs capability as knowledge-based causal discovery

以下是根据论文里提到的 prompt 模板,构造出一个问题, 模版里用到了 chain of thought 的提问方式,即要求模型先给出分析步骤,然后给出最后的选择:

Which cause-and-effect relationship is more likely? A. changing the rings causes a change in diameter. B. changing the diameter causes a change in altitude. Let’s work this out in a step by step way to be sure that we have the right answer. Then provide your final answer within the tags <Answer>A/B</Answer>.

GPT4 的回答是:

Changing the rings causes a change in diameter is more likely than changing the diameter causes a change in rings. This is because “Rings” is likely referring to the age of an object, which is a causative factor that directly affects its physical dimension such as diameter. In contrast, changing the diameter of an object cannot directly cause a change in altitude unless the object’s weight or density is changed, which in turn can impact its altitude if it is in an air or fluid medium. However, this relationship is not established in the given context, so we cannot assume B as a likely cause-effect relationship. Therefore, A is more likely than B. A

由于是直接在 chatgpt 网页中对话, 无法设置 system message 为论文里提到的 "You are a helpful assistant for causal reasoning", 但以上回答还是不错的。

这里的问题在于,gpt 大概率是读过数据集的,正如前文直接让它介绍 Tübingen 数据集时,它能够有详细的说明。因此光看结果实际没有太大说服力,后文对 LLM 对数据集记忆问题做了分析。

另外,基于统计和基于知识(LLM)的方法有各自的优缺点,基于知识的方法的前提是我们已经有对这些变量的先验知识。

假如人类从某个完全陌生的星球搜集到了两组数据,要判断这两组数据背后对应的概念之间的关系,几乎只有统计方法可以使用。(最多可以把如何找到这个星球,该星球所在的星系等知识先告知 GPT 然后让 GPT 给出一个模糊的预测)

因此基于统计的方法更接近于对先验很少的未知对象的因果关系的推断。

因此,论文在 3.1.2 节中展现了在需要医学专业知识的 Neuropathic pain dataset 上的成对因果判断任务。但 GPT4 仍然有 96% 的准确率,这大概体现了 GPT4 知识的广博。

此外,论文中分析 gpt4 的输出后发现了一致性问题,这指的是 GPT 在 step by step 过程中的解释是合理的,但最后给出的结论和它的解释不一致。于是作者对 GPT4 的结果再做一次询问,对结果进行批判和纠正(类似自省,但这里是人类手动提醒模型检查刚才输出的结果)。

在 3.1.3 节,作者对基于知识(LLM)的因果发现任务进行了扩展讨论,因为作者认为一旦有了对变量概念的先验知识,就不单可以问 LLM 是 A 导致 B 还是 B 导致 A ,还可以问更多深入的问题,这些问题的术语很多不太懂,于是问 GPT:

We can ask whether a causal relationship is monotonic, whether its effects are homogeneous or not with respect to other properties. Other useful properties to identify include the time-lag of a causal relationship, whether it is stable, and whether it is subject to spillover effects. 请用中文解释这段话,包括其中的特殊概念

这段话的意思是,在探究因果关系时,我们需要考虑一些因果特性和性质。其中一个因果特性是单调性,即因果关系随着自变量的改变而单调增减。另外一个属性是均质性,即因果效应是否在其他因素上具有同样的效果。此外,我们还需要考虑时间滞后性、稳定性和溢出效应等特性。 时间滞后性指的是因果关系的效应是否会在时间上延迟或提前出现。稳定性是指该因果关系的效应是否是一直存在,还是会受到其他因素干扰而发生变化。溢出效应是指因果关系是否会影响到其他变量,造成意外的效应。 因果关系的单调性和均质性是因果推断中的两个重要概念。单调性是指在固定所有其他变量不变的情况下,因变量随着自变量的增加或减少而单调变化。如果因果关系不具有单调性,则我们很难从中得出有意义的结论。均质性是指同样的自变量值会导致相同的因变量值,即因果效应不会受到其他因素的影响。这种均质性是因果关系可重复和一般化的前提。 总之,探究因果关系时,需要考虑各种特性和属性,包括单调性、均质性、时间滞后性、稳定性和溢出效应等。通过考虑这些特性和属性,我们可以更准确地识别和理解因果关系。

这段话提到了很多因果相关的属性,因果不是只有 "是或否" 或者程度的回答,还有各类围绕因果的属性。比如,对于两个有因果关系的变量,还可以分析因果是否单调(甚至是否是非线性因果),是否同质(同质更容易导致线性因果,类似 nft 是非同质),还可以有时间性,稳定性等等。

均质性在不同数值上是具有相同的影响力和方向,这不就是线性的一种体现吗

虽然均质性和线性性可能在某些情境下有所关联,但它们并不是完全等价的概念。均质性是指对于给定的自变量,因果变量的效应在不同数值上具有相同的影响力和方向,而不受其他变量的影响。而线性性则是指因果关系可以用线性方程或模型来描述。具有均质性的因果关系可能不是线性的,反之亦然。因此,在因果关系推断中,需要注意区分这两个概念,并根据应用场景选择合适的方法和模型。

能举例说明一对线性的因果变量但不是均质的吗

当两个因果变量之间存在交互效应时,线性因果关系可能不是均质的。例如,考虑一个线性模型,其中因变量是收入,自变量是教育水平和性别。我们假设这个模型中存在一个教育水平和性别的交互作用,而该交互作用在不同性别下具有不同的影响力,即对于男性和女性,教育水平的效应是不同的。在这种情况下,因果关系是线性的,但不具有均质性,因为我们不能简单地将教育水平的效应看作是相同的,而需要考虑性别因素的影响。因此,在对因果关系进行推断时,我们需要注意所有可能的交互作用和非均质性,并使用适当

以上这句我是不太理解,但这不是本文重点,只是稍微扩展一点思路,不在此深究。

3.2 Full graph discovery

要构建整个因果图,一种暴力的做法就是把 n 个节点的图取出所有成对变量,因此进行 n(n-1)/2 次 pairwise 判断,并且要考虑变量之间是否有因果关系,所以这是一个三分类问题。

另外,因果图发现任务需要区分直接因果和间接因果(图里的边只表示直接因果),如果存在 A->B->C 因果链,且 A 都是通过 B 影响 C , 那么 A 到 C 不能有边。因此,对于因果图构建,需要考虑全局性的约束,问题更难。

论文的简化方法是:找出 100 对变量,其中 50 对没有因果,另外 50 对有因果关系,还是做 pairwise 判断,只不过这里是三分类。

对于这 100 对变量,一个随机的二分类算法的召回率是 0.5, 因为其中 50 对有因果关系的 pair 中,有 25 对会被预测正确, 而召回率的分母只计算那些有因果关系的 ground truth(也就是 50)。而精度是 0.25, 因为它对所有 pair 都给出了一个因果方向,因此分母是 100.

在 3.2.2 节, 作者转向了 Arctic sea ice dataset, 由于其中只有 12 个变量,因此可以进行整个因果图的构建,并且用因果图的测量标准来检验,使用的 prompt 也是以上三分类的。

文中采用的因果图检验的 metric 是 normalized Hamming distance (NHD), 即求两个 0/1 矩阵的 hamming 距离。 对于北冰洋数据集,有 12 个变量,因此两两组合的因果关系可能对有 12*12=144 对,可以把它看作一个 12x12 的 0/1 矩阵 M,M[i][j]= 1 表示变量 i 是变量 j 的直接因,0 表示没有关系,由于是有向图,因此这个矩阵不是对称的。

该数据集的 ground truth 中有 48 对因果关系。因此如果预测中也预测了 48 对,但都预测错了的话,就有 48*2 个矩阵位置都不匹配,那么 NHD 距离是:

nums = 12

48*2/(12*12)

0.6666666666666666

距离越大说明预测效果越差。如果全部都预测成 0, 那么距离实际更小

48/(12*12)

0.3333333333333333

因此,要对保守的模型进行惩罚(预测的数量越少惩罚越大),例如如果某个模型预测了 9 个,那么它最差的 NHD 是在 9 个全部预测错的情况,也就是 (9+48)/(12**2)=0.395 所以,文中给出的 ratio 是 NHD 除以这个最差情况的 NHD, 以下是 table 7 中 baseline NHD 的计算:

for predict in [9, 15, 7, 23, 16, 62, 46]:

print((predict+48)/(12*12))

0.3958333333333333 0.4375 0.3819444444444444 0.4930555555555556 0.4444444444444444 0.7638888888888888 0.6527777777777778

论文描写到, gpt-4 由于预测了 46 个 edge, 其中预测对了 29 个,因此精度和 recall,f1 分别为

p = 29/46

r = 29/48

f1 = 2*p*r/(p+r)

print(p, r, f1)

0.6304347826086957 0.6041666666666666 0.6170212765957447

最后 f1 和论文的 0.57 对不上,不知道为何

而 gpt-4 NHD 的计算:

(48-29+46-29)/(12*12)

0.25

和 0.22 也不太对的上(但区间接近)

0.22*(12*12)

31.68

3.3 Probing LLM behavior further

记忆化测试(Memorization Test) 用来检查 LLM 记住了多少数据集,具体方法是: 给出测试集的前三列数据,让模型预测之后的内容,发现 GPT4 能补全 61% 的剩余表格,因此说明模型看过 Tubingen 的测试集(不过作者提到这个比例还是比它准确率低许多,但这种比较无法说明模型泛化能力)

个人体会是,本节分析给出的数据没法对上一节得到的(超高)准确率进行校准,只能有一个大体的认识,即上一节的准确率很大程度是作弊的,不过即便作弊也能说明 LLM 记忆能力超群。

Redaction Test: 由于测试中,每一个问题用的都是同一个 prompt, 因此可以对整个 prompt 进行删除测试,比如假设 prompt 有 100 个词,那么可以做 100 次实验,每次删除其中第 i 个词后提问,检查准确率是否下降,如果下降越多,则说明这个词对 prompt 越重要。 做这个实验大概是因为作者提到,之前有研究团队在相同数据集上测试过 GPT4 的因果发现能力,但效果很差, 而本文只是重新设计了 prompt 却得到了 SOTA 结果,因此主要是体现 prompt 工程的重要性?

4 实际因果

传统的实际因果推断一般要借助 SCM, 要么是因果结构方程,要么是因果结构图, 但人类做因果推理的时候,许多背景知识很难有效地形式化成一个 SCM, 而 LLM 则隐含地编码了这些背景知识。

难以形式化的背景知识包括:

- Causal frame: 与特定结果事件相关的候选因果事件的集合。 比如说某个人坠楼,我们一般不会考虑万有引力是坠楼的原因,尽管它确实是必要因。有很多潜在性的常识性背景知识来支撑人进行更准确而合理的因果判断,但很难把这些都量化到因果图或方程中,而如果完全不考虑这些常识,得到的结果又会有偏差。

- Necessary causality: 如何说清楚某个原因是必要的

- Sufficient causality: 如何说清楚某个原因是充分的

- Normality: 果事件与统计规范或规定规范(社会、道德或法律规范)的一致程度。 当行为体违反规范时,他们通常被判断为结果的更大的原因。

其他人类因素: 包括偏向行动、处理意图和认知状态,以及如何解释不良结果。 当候选原因是一个行为体的行为时,人们倾向于将更多的因果性归因于行动(例如,抛掷香烟) 而不是缺乏行动(例如,没有进行控制燃烧)。 此外,当候选原因是行为体的行为时,行为体是否有意图并知道他们在做什么也很重要。 最后,人类的因果判断也取决于结果是否不受欢迎(例如,引起森林火灾与引起重新造林计划)

充分因和必要因的对话解释:

为什么说必要因和充分因很难形式化?

在因果推断中,必要性和充分性是两个关键概念,但在结构性因果模型(SCMs)中形式化它们是具有挑战性的。原因主要有以下几点:

- **复杂性和不确定性**:在现实世界中,因果关系往往涉及到大量的变量和复杂的相互作用。确定一个事件是否是另一个事件的必要或充分条件,需要对所有可能的情况进行全面的分析,这在许多情况下是非常困难的。

- **主观性和解释性**:必要性和充分性的判断往往涉及到主观的解释和评估。例如,我们可能会说,水和阳光是植物生长的必要条件,但是否可以说它们是充分条件呢?这取决于我们如何解释“充分”。如果我们只考虑物理和生物学的因素,那么答案可能是肯定的;但如果我们还考虑到其他的因素,比如经济、社会或文化因素,那么答案可能就不那么明确了。

- **因果关系的动态性**:在许多情况下,一个事件对另一个事件的影响可能会随着时间和条件的变化而变化。例如,教育可能是提高个人收入的一个充分条件,但这可能会受到经济环境、个人能力、社会政策等因素的影响。在这种情况下,将教育视为一个静态的“充分条件”可能就过于简化了。

以上这些因素都使得在SCMs中形式化必要性和充分性成为一项具有挑战性的任务。

本章的脉络是:

- 先介绍反事实以及 LLM 如何在反事实相关的因果问题上接近人类的准确率(低 6 个百分点)

- 介绍充分因和必要因以及 LLM 如何回答与之相关的相关问题

- 在 Big Benchmark 里的因果判断 benchmark 上对候选原因做 normality 分析。

4.1 Building block of actual causality: Counterfactual reasoning

首先理解,为什么反事实是 actual causality 的重要手段而在 type causality 却基本没有提及

为什么在 type causality 里不提反事实

类型因果性(Type Causality)和实际因果性(Actual Causality)是因果推断的两个不同层面,它们关注的问题和方法有所不同。

类型因果性主要关注变量之间的平均因果效应,它通常基于大量的观察数据,并使用统计方法来估计因果效应。在这个层面上,我们通常关注的是“一般来说,变量A的变化会导致变量B的什么样的变化”。因为我们有大量的数据,我们可以通过比较不同的观察情况来估计因果效应,而不需要进行反事实推理。

实际因果性则关注特定事件的因果关系,它通常需要进行反事实推理。在这个层面上,我们关注的是“在这个特定的情况下,事件A的发生是事件B发生的原因吗?”。因为我们只有一个特定的情况,我们不能通过比较不同的观察情况来估计因果效应,而需要进行反事实推理。

因此,虽然反事实推理在实际因果推断中起着关键作用,但在类型因果推断中,我们通常可以通过其他的方法来估计因果效应,而不需要进行反事实推理。

一种朴素的定义实际因果的方法就是用反事实:

an event A is a cause of another event B if B would not have happened without A.

以上定义了事件 A 是事件 B 的(实际)原因,定义的方法就是用反事实,即如果 A 不发生,那么 B 也不会发生。 注意这里 A 和 B 的因果关系就是一种个例的实际因果,因为:

- 只有个例情况下我们才能够讨论 "发生" 与"不发生". 在 "类型"(type)的世界里,我们一般不讨论发生与不发生, 而是讨论平均影响,关注的重点是不同的。

- 另外,这种定义是错误的(所以是朴素的),例如如果 A->B, A->C 且 B 和 C 都只有在 A 发生的情况下才会出现,那么这意味着,如果 B 不发生(那么 A 也没有发生)那么 C 也不会发生,但 B 不是 C 的原因。

Necessary causality: The property of an event, C, that if it had not occurred, then the outcome event, E, would not have occurred. 这么说这和实际因果的定义 an event A is a cause of another event B if B would not have happened without A. 不是一样的吗

CRASS (Counterfactual Reasoning Assessment) 数据集:给定各种场景,以及该场景的反事实问题,从选项总选择最有可能情况,一个例子如下:

- 场景是: A doctor washes their hands at work.

- 反事实场景是: What would have happened if the doctor hadn’t washed their hands?

- 问题选项: A. The patients could get an infection.; B. The patients could get better.; C. That is not possible

另外该数据集是 2022 年发布,因此 GPT4 的训练集里理论上没有看过原文。

4.2 Inferring actual causality: Necessary and sufficient causes

Necessary causality: 必要因的概念和上一节对实际因果的朴素定义是完全一致的,是一种反事实定义,即如果 原因事件 C 不发生那么结果 E 也不会发生,则称 C 是必要因,或者说 C 具有必要性。

实际因果性(Actual Causality)的定义和必要因果性(Necessary Causality)的定义在很大程度上是一致的。它们都是基于反事实推理:如果没有事件A(或C),事件B(或E)就不会发生。

然而,这两个概念的应用上下文和侧重点可能有所不同。实际因果性通常用于描述特定事件的因果关系,而必要因果性则更多地用于描述一般的或理论的因果关系。例如,我们可能会说,根据必要因果性,没有氧气,火就不能燃烧;而在实际因果性的框架下,我们可能会说,在特定的火灾事件中,是因为某人的疏忽导致了火源的产生。

总的来说,这两个概念都是因果推断的重要工具,它们都基于反事实推理,但在应用上下文和侧重点上可能有所不同。

从计算上来看,我们只需要考虑 C 不发生这一种反事实情形就可以分析 C 的必要性。因此如果要借助 GPT 来分析必要性,只需要先描述原因 C 和 结果 E, 然后问,如果 C 不发生,那么 E 是否会发生。 而在询问"如果 C 不发生" 时,模型实际要去关注除 C 以外的所有变量以判断 E 是否发生。 这相当于是一种特征转换(或者注意力切换)后的预测。

对比相关性的计算难度的话,要知道 A 和 B 是否相关,那么只需要 A 和 B 的一组观察数据,然后计算相关系数即可,相关性完全由 A, B 两个变量观测到的数据所决定,因此相关性的计算就更为简单了(不考虑条件相关的话)。

Sufficient causality 只要 C 发生那么 E 就会发生,则 C 称为充分因,或者说原因 C 具有充分性。 Judea Pearl 对充分因的定义是: \( P((E_{C=1}=1|C=0, E=0) \) 表示的是,假设 C 和 E 都没有发生的情况下,如果 C 发生了,那么 E 也发生的概率就是原因 C 的充分度。

这个定义比较曲折,需要多个反事实假设来描述,于是论文转向了从认知科学的定义(大概率转换成 prompt 提问后效果不好):

Robust sufficient causality 该定义来自认知科学,它说的是,只要 C 发生,即便那些对结果事件 E 有影响的事件 B 不发生, E 也会发生。 这个定义引入了其他外部的变量 B (或者更多其他变量), 因此涉及到了 causal frame 问题,也就是说,除了给定的几个主要变量之外,需要从背景或环境中找到更多的对结果 E 有影响的变量(事件), 并且如果找到的变量对 E 的影响越大,那么越能说明 C 的充分性。

这不禁让人想到以下观点:

The key to understanding complicated things is to know what not to look at and what not compute and what not to think.

– Gerald Jay Sussman

因此,对于充分因的判断,需要拆分问题,先问 LLM 找出所有与结果 E 有关的原因,然后再问,如果这些原因都没有发生,只有 C 发生了,E 是否还会发生。

实验部分,论文使用了来自Kueffner (2021)的15个小故事 (vignettes)作为测试样本。这些小故事被广泛用于在文献中讨论和批评实际因果性的定义,并涵盖了七种具有挑战性的情境:

- 对称过度决定(Symmetric Overdetermination):这种情况下,两个或更多的因素都足以引起结果,且它们都发生了。 例如,A, B 都用大力气扔石头砸窗户,无论撤销哪一个人的动作,结果还是会发生,因此单个动作都不是必要的,却都是充分的。

- Switch:某个事件改变了结果发生的方式,但不会改变最终状态,例如 A 冲到马路去救即将被小汽车撞的 B, 把 B 推开导致 B 被大客车撞击。最终结果 B 都是死亡。A 对 B 的死亡不是必要的,但却是充分的,因为 A 的动作足以导致 B 被大客车撞击。

- 迟到的抢占(late preemption):两个会导致相同结果的事情同时发生,但只有一个能够先产生影响,比如 A, B 同时用足以打破玻璃的力量朝着玻璃扔石头,但 A 的石头先打破玻璃,那么 B 的动作就迟到了。从结果上看, B 是白费了力气。这种情况下 A 扔石头不是必要的(因为即便不扔,B 的石头也会打破),但却是充分的。而 B 压根不是原因(在法律上似乎不能如此认定,B 应该也会追责)。

- Early Preemption: A, B 都想扔石头砸烂玻璃,但 B 还没出手, A 就已经砸出去并打破了玻璃。这种情况 B 甚至没有发起活动,但 A 仍然充分非必要,因为 A 没有扔出去,B 就会出手。

- Double Preemption: B 想阻止 A 扔石头,但 B 被 C 阻止了, 因此 A 还是把窗户砸了。这种情况 A 是窗户破碎必要因,但不是充分,因为如果 B 没有被阻止,窗户不会破裂。:

- Bogus Preemption: B 阻止了 A 扔石头,但 A 其实只是假装扔石头,因此 A, B 都不是充分也不是必要。

- Short Circuit:

这部分的 prompt 也是借助 chatgpt 构造的,让 chatgpt 来给出描述充分和必要因的词汇:

- 必要因对应的词汇是: minimal change principle

- 充分因对应的词汇是: multiple sufficient causes

结果发现在必要因上的准确率比充分因上的要高,这验证了前文对必要因充分因难度的分析。

4.3 Evaluating LLMs ability to infer normality

用来检查各种原因中,是否有些原因是违背社会规则的情况,比如某人坠楼,地心引力肯定是一种必要因,但这对分析坠楼原因没有什么帮助,我们想要获得的是一种带有更多 ”意料之外“ 的原因,这是"追责"或者 "归因" 的关键。

这部分数据来自 Big-Bench, 该数据集每一条对应一个故事,一个问题(A 是否是 B 的原因)和 yes/no 的 label 作者在词基础上对原因做进一步标准,区分是 normal 还是 abnormal

这部分先是让 gpt 从故事中提取出原因事件,然后给它解释什么是 normal 什么是 abnormal, 再判断该原因事件是否符合常规。

5 A New Frontier for Causality

本节对未来的展望,在有了 LLM 这种"博学的自然语言接口工具" 后,因果科学会有哪些变化:

- LLM 可以提供难以形式化的背景知识,如何利用这些知识与统计方法结合?

- LLM 能够从问题背景中找出必要因,充分因等,因此可以让 LLM 做类似变量提取的辅助工作,然后再把变量交给更严格的模型进行推断。

哪些不变:

- 高风险和高价值的任务,还是要严格的分析过程,LLM 的输出需要能够被严格的形式系统检验或者对齐

5.1 Implications for Causality Practitioners – 构造 因果 Agent

One of the key reasons causal methods are not widely deployed is because using them requires expertise in expressing the causal assumptions formally through a graph and then verifying them through robustness checks.

人们分析因果的方法一般是先用自己的经验构造总体的变量之间的结构,然后转向统计方法 这里实际是在描述构造一个因果分析 agent 的想法。

可以先把变量的描述交给 GPT, 让它构建一个初步的因果图,然后人类再求修正,因此 LLM 也许可以和 DoWhy, EconML, Ananke 等因果统计分析工具结合构造新的工具(这些都是微软主导的开源的因果分析工具,而本文团队以及 GPT4 的东家也是微软,因此这些都可看作微软的生态布局)。在 F1 附录中还给出了如何让 GPT4 写 PyWhy 代码做因果分析的例子。

5.2 New research questions on causality and LLMs

新的方向和问题:

- 结合 LLM 的因果发现,通过 LLM 先构造一个初步的因果图然后进行分析,让 LLM 根据数据的描述信息确定一个先验的因果结构。 提到了 Choi 2022 论文展现的例子。 新的算法可以结合 metadata 和数据样本点,让 LLM 方法和协方差方法共同协作。 LLM 也可以充当协方差方法得到的结果的校验者

- LLM-guided effect inference

利用 LLM 来辅助发掘

- adjustment set

- backdoor sets

- instrumental variables

Understanding and improving causal reasoning in LLMs. 这一节提到了比较"大的问题": 为什么 LLM 可以绕过因果之梯而回答反事实问题?

Willig et al. (2023) offer a potential explanation by suggesting that LLMs sidestep the causal hierarchy by learning correlations of causal facts from the training data, rather than learning to reason causally.

这或许可以解释,为什么模型在 pairwise 任务上能够达到 90% 多的准确率,但那些错误的回答却错的很离谱(同等能力的人类几乎不会犯这类错误),因为模型可能学习到的是人们描述因果的词句之间的相关性,而在描述因果的场景下,词汇的相关性很大程度上"反映"了因果性。

个人的看法

Judea pearl 的因果之梯是针对纯表格数据来构建的,它把因果关系作为先验编码在因果图里,同时结合大量的因果假设(例如模块性等),于是"数据 + 图结构 + 假设" 组合就可以回答部分干预和反事实问题了,它的好处是提供了一个方便计算机计算的形式系统,只要有图和数据,并且假设不会与现实差太远,就可以自动计算因果效应了。

大语言模型是把因果先验(可能有错误)放在自然语言或者模型参数里,它没有太多假设,也没有利用图结构,问题就在于如何能够结合在一起?

想想有哪些结合方法:

- Pipeline 方法,把因果图和 LLM 前后拼接:

LLM 在前,因果图在后:或许可以先用 LLM 从数据的元信息里抽取出因果关系,构建因果网络,然后做传统的因果推断。

这种方式的问题是误差传播,LLM 输出的可能不准确,在不准确的图上作推断会放大偏差。当然可以人为检查 LLM 输出的图结果,但这种做法似乎更多是一种实践组合,研究价值不是很高。(属于 suggestion for Practitioners)

- 因果图在前,LLM 在后: 这种场景似乎把因果图作为一个 LLM 序列生成的引导器?

- 特征融合:

- 似乎很难把因果图作为输入来引导 LLM, 是否有因果图嵌入的研究?

- 表格数据还是很重要,它表示的是人们已经对某些特征有固定的处理手段,于是只要搜集数据即可,这类数据如何能与 LLM 结合?这更像是让 LLM 学会做自动数据分析,能够调用固定的库去处理。这又变成 LLM agent 了

- 因果先验来增强知识图谱?

Can Large Language Models Infer Causation from Correlation?

本章是对论文 (Jin et al., 2023) 的理解以及围绕该论文与 AI 的对话,不像上一章那样按照论文顺序解读(该方式的解读可参考 [Paper Reading] 大模型可以从相关性中推出因果关系吗? - 知乎)

本论文和上一章的论文思路以及结论都似乎是相对的,在上章最后个人看法中提到,以 Judea Pearl 为代表的因果推断是基于纯表格数据的,例如研究吸烟是否对健康有害的时候,"吸烟" 和 "健康" 是两个符号变量,人类通过理解了这两个变量的某些含义后,去找到了吸烟和没有吸烟的人,于是这两组人群就从某种意义上代表了 "吸烟" 这个概念,表格中会出现一列,如果某人吸烟,该值就是 1 否则就是 0. 如果继续基于人类对时间概念的把握,还可以对每个人吸烟的时长做统计,做成表格中新的一列。 接着根据人类对 "健康" 概念的理解,对这群人搜集了健康相关数据(例如根据血常规等化验结果得到此人是否健康的结果,用 0 和 1 表示),此外还需要根据其他人类知识和直觉搜集更多的列,比如性别,有无其他不良习惯,基因等等。

有了这些结果之后,我们还只能进行相关性分析,通过相关性分析有可能能够得到因果图(比如因果发现,但大部分情况得到的是部分因果图,即该论文里提到的 markov 等价类)。而为了进行因果推断,比如想更精确知道吸烟对健康影响的程度,就需要这些变量之间的先验因果信息,这种信息可以是定性的,然后结合表格数据得到定量的因果效应。

而上一篇文章完全不需要表格数据,它直接是在概念层面(meta data),或者说是符号共现层面,这里不单单是 "吸烟" 和 "健康" 经常一起出现, 更重要的是,表示他们关系的连接词(以及表达的顺序性)也在文本中大量体现出来,比如 "吸烟", "有害","健康" 常常一起出现,而"有害" 是一个很强的因果连接词。在一般的科学研究中,我们不会把 "有害", 或者 "导致" 等概念也作为表格里的一列,因为这些词似乎不是科学观测的对象或特征,一方面他们只出现在语言或者概念世界里, 另一方面这些词的形式是稀疏的,如何能搜集到所有和”有害“相近的负面关系的词呢?或者如何搜集所有与"健康"有关的词的频率?这使得我们又要回到深度学习的分布式表征中。当然我们也很难用这些词的共现去精确估计因果效应,因此两种方式似乎各有所长。

你如何评价以上对因果分析两种不同层面方式的理解

以下是我对您描述的两种方式的评价:

- 表格数据的因果推断:

- 优点:

- 结构化: 表格数据为结构化数据,易于进行统计分析和建模。

- 量化: 可以为每个变量提供具体的数值,便于进行精确的估计和预测。

- 明确性: 变量之间的关系可以通过明确的数学模型来描述,如回归模型、结构方程模型等。

- 缺点:

- 数据收集难度: 需要大量的数据收集工作,可能受到测量误差的影响。

- 先验知识: 需要对因果关系有一定的先验知识,否则可能导致伪相关或遗漏变量。

- 优点:

- 符号共现的因果分析:

- 优点:

- 直观: 基于文本的分析更加直观,可以捕捉到概念和语境的细微差异。

- 灵活性: 不受固定数据结构的限制,可以捕捉到更丰富的信息。

- 大数据: 有大量的文本数据可供分析,如科学文献、新闻报道等。

- 缺点:

- 模糊性: 文本数据的解释可能存在模糊性,需要复杂的自然语言处理技术。

- 难以量化: 符号共现的关系难以量化,可能无法提供精确的因果效应估计。

- 优点:

总体上,两种方式各有优劣,选择哪种方式取决于研究的目的、可用的数据和技术手段。在实际应用中,结合两种方式可能会得到更全面和准确的结果。例如,可以先使用符号共现的方式进行初步的因果关系探索,然后再使用表格数据进行深入的因果效应估计。

此外,深度学习和其他先进的机器学习技术为因果分析提供了新的可能性。例如,可以使用深度学习模型来学习文本数据中的因果关系,然后将这些关系转化为结构化的因果图,从而进行更深入的因果推断。

本文采用了从表格数据出发的"纯因果推断"视角去测试 LLM, 作者构造了一个包含 400k 样本的 CORR2CAUSE 数据集用来检验纯因果推断能力,结果是:

- 在 LLMs 上直接测试结果很差

- 接着在 LLMs 上进行 finetune 之后效果变好,但由于该数据集是人工构造的,其中的概念是用符号变量(如 A,B,C)表示,因此可以自动对这些符号或者句式进行替换从而生成更多的对抗样本(或 OOD 样本),在微调后的模型上测试 OOD 数据集,效果还是不佳,因此 LLM 对该任务的泛化能力不强。

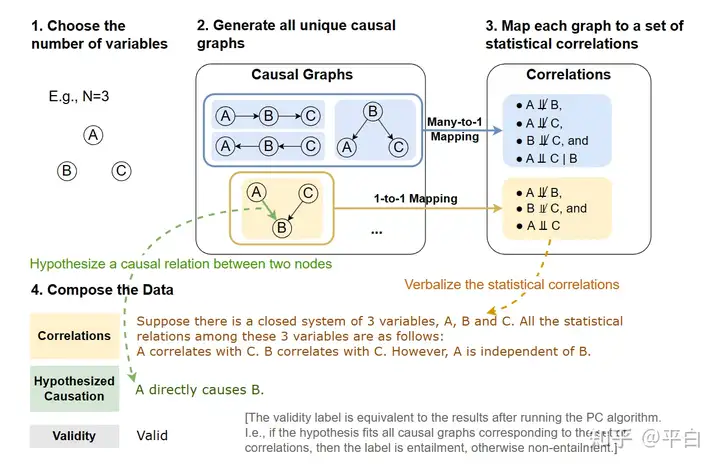

构造数据集的方法是:

- 给定节点数量 N,生成所有可能的有向无环图,根据马尔可夫等价性找出相同的等价类,

- 对每个等价类里的变量用相关性术语描述各个节点之间的关系,作为问题背景,而问题则是两个变量之间的因果性,比如 A 是否是 B 的因(如果 ground truth 是 1 ,则说明该等价类里所有)

整个过程论文中图 2 展示的很清晰:

读完论文后,我想到了一个故事:

曾经有个人,混进了一个全是博士的群里。

有一天,他发现博士们正在讨论“一滴水从高处落下来能不能砸死一个人?”这个问题。

博士们各抒己见,又是证明,又是计算,聊得不亦乐乎。

然后这个人弱弱的问了一句:“难道你们没有淋过雨么?”

博士们全都不说话了……

你觉得这个故事和以上提到因果推理两种方式有什么关系

这个段子和您提到的因果推理的两种方式之间存在一定的相似性,主要体现在以下几点:

- 复杂性与简单性的对比:

- 段子中,博士们通过复杂的证明和计算来探讨一个问题,而这个问题的答案其实可以通过简单的常识来得到。这与因果推理中基于表格数据的方法相似,后者需要大量的数据收集、建模和分析,但有时可能忽略了一些简单而直观的事实。

- 另一方面,符号共现的因果分析方法更加直观和简单,只需要分析文本中的词汇和概念的关系,而不需要复杂的数据收集和建模。这与段子中那个人提出的简单问题相似。

- 直观性与深度的权衡:

- 博士们的讨论可能更加深入和科学,但可能缺乏对问题的直观理解。同样,基于表格数据的因果推理方法可能更加精确和深入,但可能忽略了一些直观的事实和常识。

- 符号共现的因果分析方法则更加直观,但可能缺乏深度和精确性。

- 过度复杂化的风险:

- 段子中,博士们可能过度复杂化了一个简单的问题,导致忽略了最直接的答案。这提醒我们在进行因果推理时,需要注意不要过度复杂化问题,而应该结合多种方法和视角来得到更全面和准确的结果。

总的来说,这个段子与您提到的因果推理的两种方式之间存在一定的相似性和联系,都反映了在科学研究和实际生活中,简单与复杂、直观与深入之间的权衡和选择。

这个段子多少有点 "反科学精神" 的倾向,因此最后还是要加上一点提醒,大部分科学发现还是来自于表格数据里定量的分析,概念层面更多是提供引导的,假设人类未来进入到一个完全陌生的星球,其中的每个物体、生物都与地球上的很不一样,那么这个时候概念上的类比作用可能很弱,更多是帮助我们区分事物的差别性,人类可能还是要对一个个独立的对象测量并搜集表格数据,再从表格上进行统计发现,根据发现结果给该星球上每一个物体都取了新的名字之后,概念世界才开始出现。