人工智能中的大观念

修改历史

- 添加 weak-to-strong 一节

- 添加统计和因果一节随记,等待整理

本文整理人工智能领域里常出现的一些"大观念"(big idea), 其中一些是有启发性的,有些是飘渺的,还有些是错误的。 正因如此,我觉得它们应该被单独整理出来置于一旁,以便能够以一种统一的视角来审视,避免在编写代码的过程中,它们突然出现,扰乱了思路。

由于人工智能这个概念或学科过于庞杂,本文只能整理出个人关注过的一小部分,并且各个大章节之间并没有依赖关系。

1. 过度优化适得其反

当一项测量手段本身成了目标,那它就不再是一个好的测量手段。

机器学习中训练过拟合可以看作是 goodhart 定律的一种体现:

- 一方面,我们不能直接去优化目标数据集(测试集),而是要找一些代理数据集去训练学习

- 另一方面,我们在代理数据集上又不能过度学习,否则会适得其反。需要达到一种平衡。

这引出了经验风险最小化和泛化误差估计等理论概念(empirical risk minimization and estimating the generalization error)

本章参考:

2. 人工智能与社会

2.1. ELIZA: 图灵测试的陷阱

1960 年代,人工智能在下棋,逻辑定理证明方面有许多进展,但却在自然语言处理(NLP) 上碰壁,许多人认为语言能力涉及到外部知识和常识,几乎等同于思考能力,很难让机器理解语言。

Melanie Mitchell 用了一个例子来说明,在 “a steel ball fell on a glass table and it shattered.” 中,根据常识,人们很容易判断其中代词 it 表示的是 glass table 而不是 steel ball, 这是因为我们有对玻璃和铁硬度的认识,知道铁球与玻璃碰撞,玻璃应该是碎掉的一方。但光靠语法规则去解析是无法判断 it 指代哪个的。

这个例子属于 Winograd schema challenge 的一种,这类问题实际可以用 big data trick 来解决(或许深度学习大部分问题都是 big data trick),因为 glass 和 shattered 出现的频率显然比 steel 和 shattered 的频率高,因此通过词共现频率特征训练的模型很大概率可以正确识别这类指代,可以参考 (Levesque, 2014)

由于这类问题,五六十年代的对话机器人基本类似一个交互搜索系统,用形式化的搜索语言去查找固定领域的结构化的知识,然后按语法规则把知识组起来,对话体验非常生硬。

Joseph Weizenbaum 就是在此背景下开始研究对话机器人,他发现实际可以在机器人不了解任何外部知识的情况下实现比较"自然"的对话,秘诀就是让机器在适当的时机把问题转移回用户: "It wouldn’t spit out facts. It would reflect back at the user, like a mirror."

这个发现其实源于他的心理学背景和兴趣。当时的心理治疗方法主要采用的是“话语术”,其中,心理咨询师的角色主要是倾听和引导患者,而并不过多地发表自己的观点。正是基于这种技巧,ELIZA 得以开发出来,它成功地让人们打开心扉,愿意与其进行深入的对话。

- ELIZA 的出现可以看作是对图灵测试的某种反驳:机器没有智能,但是能够让人以为它是人

- 这也是 goodhart 定律的一种体现:只是为了欺骗人类相信自己而对话,实际得到的并不是最初想要的”智能“

- Weizenbaum 发现 ELIZA 的能力后,发现人类的脆弱,开始反对用机器来替代人类作为情感交流的角色,从此离开了 AI 界。

然而许多人不认为用机器来进行情感服务(如心理咨询)是一种欺骗,也不认为人类把 ELIZA 当作了真人,ELIZA 现象展现了人类的一个特点是——即便对方不是人,例如是树,宠物,自然,上帝,只要它能够触动自己,人类也会敞开内心与它交流。(这似乎是很明显的)

沿着这个思路,Woebot labs 推出的机器人,认为 “transparency is the basis of trust”, 它的目的不是通过图灵测试,而是在聊天开始就告诉对方自己是机器人(屏幕展现的形象等),用于疏导人们的负面情绪,它能够记录你的情绪变化,展现数据,让你更了解自己的情绪。在这个设定下,这类机器人的发展开始严肃地面对隐私,安全的问题。

本章参考

2.2. 为什么实现变革性人工智能非常、非常困难

主要参考 Why transformative artificial intelligence is really, really hard to achieve

文章更多以经济学或者社会学角度的思想来论述。这里"变革性"的内涵是对整个人类社会(各行业)都有推动作用,类似工业革命级别。

总的来说,文章认为 AI 尽管有巨大的潜力,但要实现真正的变革性影响,需要克服许多技术、社会和经济难题:

- 社会发展是系统性的,短板效应会导致发展不充分或停止。例如就算建筑设计师通过智能绘图等工具将效率提高了一倍,但盖一个房子的速度不会减少一半,因此除非能够同时对整个生产线/产业链的各个环节都提高效率,社会经济水平才会有变革性地提升。

- AI 技术发展内部的不平衡。目前 AI 的进步,包括计算机视觉,生成式 AI (生成文字,语音,图片)仍然只是自动化的一小部分,比如系鞋带这种人类非常简单的任务,机器人还无法很好解决。 结合上一条, AI 很难对总体发展产生变革性影响。

- 即便生产的各个环境都可以自动化,还有社会,政治、文化的因素。经济转型的历史是一个偶然性的历史。许多因素必须同时到位(解放思想,甚至战争驱动),而不是一个因素压倒一切。单个技术只有在制度允许其采用、激励其广泛部署,并允许围绕新技术进行大规模社会重组时,才有意义。

3. The Bitter Lesson

- 算力友好的通用搜索和学习算法最终会比利用人类领域知识精心设计的算法更加有效

- 心智是极其复杂的,我们不应该再试图把人类当前对心智理解的简单模型,例如对空间、物体、多个代理或对称性, 构建到智能系统中去。这些都是任意、本质复杂的外界的一部分。 相反,我们应该构建能够发现和捕获这种任意复杂性的元方法。

bitter lesson 提到了两个方面:可以随着数据和算力不断扩展的通用的搜索(search)和学习(learning),以下 是针对两个方面的更具体场景下的观点:

3.2. search

Parables on the Power of Planning in AI: From Poker to Diplomacy: Noam Brown (OpenAI) - YouTube

AI 发展目前更多受益于模型增大,但如何在推理端添加通用的搜索的关注度则更低。 很多问题值得更长时间的推理端思考,比如即便是世界第一的棋手,训练了几十年,面对复杂的棋局也会思考很久, 数学家并不是依靠大量训练,然后一次推理就把问题解决了,有些数学难题需要思考几个月甚至数年。

4. 人物视角

本章涵盖两类人物的视角:

- 当前 AI 领域的引领者在讲座,访谈里发表的看法

- 对当前 AI 的技术有启发或推动的历史人物的思想

4.1. Geoffrey Hinton

以下算是一个段子:

To deal with hyper-planes in a 14-dimensional space, visualize a 3-D space and say “fourteen" to yourself very loudy. Everyone does it.

’Neural Networks for Machine Learning Course L8'

Hinton 和 Ilya Sutskever 一般会用大脑神经元的数量级,计算速度,人的寿命来进行估计,从而说明一些学习范式的合理性或者 发展空间。

比如对非监督学习重要性的说明:

The brain has about \( 10^{14} \) synapses and we only live for about \( 10^{9} \) seconds. So we have a lot more parameters than data. This motivates the idea that we must do a lot of unsupervised learning since the perceptual input (including proproception) is the only place we can get \( 10^{5} \) dimensions of constraint per second"

2014 AMA on Reddit

4.2. Yann LeCun

2016 年在 NeurIPS 上用蛋糕 (LeCake) 来类比机器学习各个部分的比重

- 纯强化学习是蛋糕最上方唯一的一个小樱桃,每个学习样本提供的信息只有少量比特

- 监督学习是蛋糕表层的奶油:从观察数据中预测少量切片信息,每个学习样本提供 10-1000 bits

- 非监督学习是蛋糕主体:从观察数据中预测数据其他任何部分,每个学习样本提供百万 bits 的信息

ChatGPT 的训练基本就是符合这个模型,从海量非监督学习到指令微调再到基于人类反馈的强化学习, 数据量越来越小。所以 ChatGPT 算是最广为人知的美味的 LeCake 。

4.3. Ilya Sutskever

本节是对 Season 1 Ep. 22 OpenAI's Ilya Sutskever: The man who made AI work 里访谈关键点的记录,Ilya Sutskever 是 Openai 的首席科学家,也是图灵奖得主 Hinton 的学生,他对深度学习里最重要的几个里程碑的论文/事件都有直接贡献,包括 Alexnet, AlphaGo, chatGPT.

4.3.1. 人对视觉和语言信号的处理是毫秒级别的

Sutskever 是端对端的坚信者,他认为神经网络本质就是一个并行计算机,反向传播是在对这台计算机进行编程。在 Alexnet 之前,人们普遍认为反向传播太弱了,无法训练深度网络,只会陷入局部最优。(lenet 只是在小网络上的成功,28x28 的输入,而在大的图片数据集上,那时候 SVM 等方式效果更好)

但 James martens 等在 2010 年发表的 Deep learning via hessian-free optimization. 论文展示了可以端对端地用监督学习的方式训练深度网络,这意味着可以对"更大的并行计算机进行编程了" 。

另外一方面, Sutskever 认为人的视觉是很快速的,我们几乎在看到物体的瞬间就知道那是什么,而相对电子计算机来说,大脑的单个神经元的激活速度是比较慢的,这意味着人脑没有很深的处理视觉的神经网络,那么识别图片的人工神经网络也可以不用那么深,优化难度不会很高,因此只要有数据和算力, 他相信训练一个匹配人眼识别能力的网络是可行的。

(神经网络是并行计算,并且人脑神经元比较慢,因此不会太深的想法可能是来自 Hinton ,参见 1.2 What are neural networks_哔哩哔哩_bilibili)

巧的是,这个时候 Imagenet 数据集和 CUDA 都出现了,而他同学 Alex (Alexnet 论文一作)又已经用 CUDA 实现了 CNN 反向传播代码,因此在 CUDA 上用 Imagenet 数据训练 CNN 已是水到渠成了。

4.3.2. 不受”大观念“(可解释性)的影响

当 Alexnet 成功之后,Sutskever 想到的是,人类的语言理解和表达也是很快的,对话时,人在听到句子的同时就在不断理解。 另外在棋类游戏中,专业人员都是看到棋局后马上就能获得正确决策的直觉,这些都是快速的反映,因此他相信目前是可以解决的,因此他参与到 AlphaGo 项目中。

这里 Pieter Abbeel 问了一个个人觉得非常好的问题。他说当时人们一般是觉得 CNN 之所以成功,是因为图片识别任务里,图片特征符合 空间局部和平移不变性,比如一张猫的图片,把其中的猫平移到图片另外一个角落,识别结果应该还是猫, 但围棋棋谱中,移动局部的布局会破坏整个棋局的状态(语义),因此可能不会成功。但是 Sutskever 则完全不受这种理论解释的影响,他相信的就是人类专家可以通过视觉输入短时间里识别出棋谱的状态并且做正确决策,那么神经网络也可以。

包括之后他从视觉转向语言也是如此,完全不受当时的一些流行的可解释性思想的影响,比如 Pieter Abbeel 又问到,深度学习在图片,声音上能够提取特征,更多是对(连续的)信号在处理,因此人们普遍认为深度学习可能更适合连续信号特征的提取和处理。 但 Sutskever 继续从人脑角度树立信念,不管语言是离散还是连续,人脑就是很快能够对话交流,人的神经元速度是较慢的,人却可以反应很快,说明网络并不深,因此神经网络可以达到人的语言能力。

4.3.3. 深度学习的工程转向

Sutskever 认为, 2016 年 AlphaGo 的成功已经让 DL 从类似个人或小团队的研究(idea heavy + 部分工程化)变成了一个非常工程化的活动(engineer heavy),很多问题已经从能否训练变成如何训练更大的网络(分布式,如何 debug 大模型等),如何获取更多数据(stack quite deep)。 在 google 的 Sutskever 觉得身边环境太偏向学术,还是 idea heavy 型的。而正好那时 Elon Musk 出于对抗 google 等大公司对 AI 垄断的理念,和 Sam Altman 等人一起创建了 OpenAI 。Sutskever 认为,鉴于马斯克在特斯拉和 spaceX 这种系统工程密集型领域的成功,使得没有人比 Musk 更适合来主导工程化 AI 这件事了,于是加入到 Openai。

4.3.4. 语言模型

在 Openai 开发了 Dalle 和 GPT 系列的语言和多模态模型。

他提到 LSTM 序列网络,如果越长,相当于深度也越深,因此长度和深度互相耦合 , 数据的长度会限制模型深度,从而影响训练效率。transformer 则对深度和长度的解耦,长度不再影响深度, 因此认为 transformer 的出现非常关键,为学习更多数据打开了大门。

他相信,只要在数据量足够大的情况下,模型即便只是根据上文预测下一个词,只要损失下降,那么说明模型预测越来越准,而为了能够准确预测,模型必须理解到某些语义才行。

最后谈到了对大语言模型的对齐,通过 Instruction 和 HFRL 来引导大模型生成符合人类目的和价值的信息。

4.4. 乔姆斯基

4.4.1. 两种统计模型之争

本节参考自: On Chomsky and the Two Cultures of Statistical Learning

Chomsky 并不是反对统计学,而是反对统计学中的某种倾向,这种倾向目的在于尽可能精确的对外部建模而不是寻求 对世界或模型的某种洞见。

他赞同的另一种统计学的倾向是用大量人类的直觉和知识建立一个简单的容易解释的统计模型,例如选定正太分布模型后,只估计均值和方差就表示一大群的样本的特性,通过很少的参数化以及一个可理解的公式(规律)去"洞察"大量类似的事物。再比如万有引力公式 \( F = G \frac{m_1m_2}{r_2}\) 中的 G 和 \( E=mc^2 \) 中的 c 实际都是对自然现象的观测并推断的结果,这些物理常数也有误差和适用范围,但在这个范围内,公式非常简洁深刻,这是一种公认的"科学精神" 或者 "科学方法"。乔姆斯基自己提出的转换生成语法也是针对语言现象所建立的此类模型。

与之相对的另一种统计文化则认为世界过于复杂,关注重点不是模型的简洁性解释性,而是追求预测结果的准确性,比如机器学习模型尤其是深度学习。

然而世界所有的真相真的可以用 Chomsky 赞同的那种优雅的统计归纳方法来获得吗? 文章作者 Peter Norvig 认为世界的复杂性使得我们必须依赖更复杂的统计模型,如深度学习模型,以达到更高的预测准确性,通过实践的有效性来把深度学习作为一种可靠工具。

这里引出来的问题是: 只有一个参数的 \( E=mc^2 \) 和有 1000 多亿个参数的 chatgpt, 哪个更优美?哪个更深刻?

另外一个问题在于,深度学习真的代表另一端的统计学吗?深度学习本身就带有反传统的统计学的倾向,一般意义上统计学的研究者与深度学习研究者之间可能比以上两个类别有更多的争执,根据人为先验知识所占比例,逻辑主义和深度学习应该分别在最左边和最右边,而 Chomsky 所认为的优雅的统计学是在中间偏左的位置,一般意义上的统计学则在最中间,但它和深度学习之间还有很远的距离。深度学习内部也不断追求更少的先验,因此更多细分的频率出现在 AI 光谱的右侧,这在后文归纳偏好一节里会有更多讨论

4.4.2. 对语言层次的划分

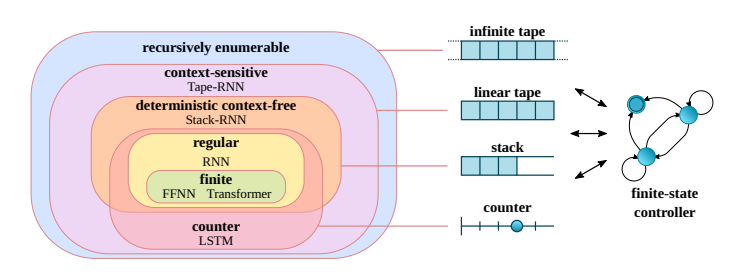

这个划分在形式化语言的研究领域(计算理论)里被大量地研究和扩展,如今也有被作为研究深度学习语言模型的参照系,比如 (Delétang et al., 2023) 论文中对不同语言分类用不同的深度学习模型建模(如图所示),从而探究从统计角度学习不同层级语言的难度以及不同模型的表征能力(对不同长度的序列的泛化能力)。

4.5. 维特根斯坦

我们已经进入迷雾

(Mikolov et al., 2013) 提出的 word2vec 分布式词向量: 词汇的意义来自于它使用的场景,这说明了语用和语义之间的关系。

尽管我对 NLP 的兴趣最初就是来自于发现 word embedding 的思想和维特根斯坦思想相近时的惊喜感。 然而这个解释非常宽泛,W 的意思实际更广,词汇对他来说不单单是句子里的词,可能还有某个动作表情等等。

抛开 W 的思想, word2vec 给启示是:

可以用非监督的方式在语言上进行训练而获得有意义的结果,这意味着语言内部结构本身就蕴含了所有的关于语言的知识,很可能不需要借助"外部世界"。

本节参考:

5. 归纳偏好

英文名为 inductive bias, 一般翻译成归纳偏置,但"偏置"一词不太好理解,因此这里就用"偏好"来代替。

归纳偏好指的是在对现象进行归纳学习之前,给模型预设的假设。这个概念很有"哲学"味道,因为要说清楚它就得去思考一些看似理所当然的东西,同时这个概念抽象程度又很高(毕竟是用来修饰"归纳"的),因此对实际指导作用不大,却能够给人一点启发和烦恼。

它大概率是来自哲学或者认知科学, 比如莱布尼茨和洛克的天赋观念和白板说之争,分析命题和综合命题,康德对认知层次的划分等等(先验感性,先验知性)都像是在讨论归纳的偏好。

这里还是以简单的例子来说明,假设给你以下几个数:

1,2,3,4,5,6,7

请预测接下来的数是什么? 如果回答是 8 ,则说明我们至少对两个假设/偏好根深蒂固了:

- 对"顺序"的偏好:我们一般就是从左到右看的,因此你会觉得”接下来“应该写在最右边,而不是往左边添个 0. 更不会认为它是一个无序的集合,因此加到哪里都行。

- 对"数数"的偏好:我们从小就是学习从 1 数到 10,因此自然的会想到接下来是 8. 但如果我们是在讨论八进制数数,那么下一个数应该就是 0.

用数学一点的话来说,我们默认用 f(x)=x 来拟合以上的数据,定义域 x 是一种"序数"(而不是随机数), 但如果我们生活在 8 进制的世界里,那么这种 "八进制" 归纳偏好会使得我们用 f(x)=x%8 去拟合以上数据。

在没有假设的情况下,以上序列有无数种解释,因此要教会机器做归纳,要思考如何把偏好用代码加入到模型或算法里去,同时要检查这些对人类来说理所当然的偏好对机器来说是否是多此一举甚至有害,因此需要大量的实验,通过经验来证明。

实际上,机器学习里任何算法或模型的设计细节都可以对应上某种归纳偏置:

- 奥卡姆剃刀原则也可以看作一种通用的归纳偏好,而 relu 是对该偏好的一种实现(一种更具体的归纳偏好),因为 relu 可以说是最简单的非线性函数了。

- 深度学习整个领域都属于 "数据是分层表征" 的这个归纳假设下。而线性回归则是在”数据特征符合线性组合“的归纳偏好下。

- transformer 中的位置编码就是对 "从左到右顺序"的偏好,这个偏好来自语言里词汇的有序性。

- CNN 卷积层的局部性

- 梯度下降,随机初始化方法等

- 整个统计学习算法的独立同分布假设

总的来说:归纳偏好越多(强),相当于历史包袱越重,模型通用性越差。归纳偏好越弱,模型越不容易学习 (Delétang et al., 2023)

应警惕对概念的过度使用,当一个概念逐渐走向"大一统"的时候,本身就在失去某种归纳偏好,这与 goodhart 定律类似。 深度学习的趋势就是去掉更多先验的假设,只留下能够让机器高效学习的结构设计,剩下的都从数据里学。而很多设计更多出于工程上的偏好,比如 LSTM 论文还会讨论一些大脑或认知的先验知识作为设计参考,但 transformer 论文只讨论计算复杂度优势了。

5.1. 自省性的归纳偏好:奥卡姆剃刀

一种最通用的偏好,因为它在审视模型自己的复杂度(因此与熵等概念联系密切),有点断舍离的味道。

但它引出的问题是:什么是复杂,什么是简单?

比如激活函数 relu(x) = max(0, x) 是不是一种奥卡姆剃刀式的归纳偏执?也是可以这么解释的,但似乎不能给人带什来什么指导,这些解释的统一更多是副产物。

170B 参数的 GPT3 模型符合奥卡姆剃刀原则吗?

5.2. 先验的空间和时间

"空间和时间是先验的",这种表达最初可能来自康德。

5.2.1. 序列的绝对时空

计算机科学里,很多时候空间和时间可以互换,例如动态规划算法里有大量的空间换时间的例子,深度学习中, RNN/LSTM 是专为序列设计的模型,它选择用输入的先后顺序(计算的时间顺序) 来表达序列的先后顺序(也许是序列生成的时间性),有点时间换空间的感觉。这带来的问题是,模型输入序列有多长,网络就要有多深,网络深度和序列长度耦合,序列越长计算时间也越多,而网络越深也会导致越难训练。

但 transformer 把序列的"时间"编码到空间中(位置编码), "时间"仅仅被看作了一种特殊的特征通道。

5.2.2. 相对位置编码:序列的相对时空

相对位置编码的思想大概是这样的:它不是把位置编码放在某个 token 上,而是放在 token 之间的交互上,尽管对于 k 个 token,有 k(k-1) 种两两组合的交互,但实际对于相对位置,特征数塌缩到了 2k-1 ,因此需要准备 2k-1 种固定 embedding 或者可学习的 embedding, 加入到 token 的交互运算中,由于 self attention 就是在做 token 的两两交互,于是把相对位置编码从自注意力层注入是比较自然的,这样就把位置和 token 进行了解耦。

另一种思路是仍然保留绝对位置编码,但要让编码方式"迎合"自注意力机制。 比如说,假设模型使用了一种减法自注意力层,它会在两两 token 的表征之间做减法,那么对于一个序列,我们可以直接用 1,2,3,4,5 这样的数字来表示其绝对位置编码, 因为在减法注意力层会算出 token 特征的相对距离,包括 -4,-3,-2,-1,0,1,2,3,4. 模型就获得了相对位置信息。

然而,目前的 attention 都是在特征之间做乘法(向量内积,余弦相似度),如何能够在乘法里得到减法? 由于在指数空间的乘法是可以转换为加法,因此一种做法是, 把绝对位置取指数后作为表征与词向量相加,然后对 query 向量取反去做 attention, 得到的 self attention 中就会获得相对位置信息。 Rope 的大致思路是这样的,

由于复数可以写成指数形式,因此也可以用复数运算来理解。

5.2.3. 空间局部性和平移不变性

这部分直接交给 GPT 了:

卷积神经网络(Convolutional Neural Networks,CNN)的归纳偏置就体现在其对局部和平移不变性的偏好。 详细介绍一下,并说明为什么卷积网络可以识别围棋图片?

卷积神经网络(Convolutional Neural Networks,CNN)的设计灵感来源于生物视觉系统的结构,特别是对于局部感受野和空间不变性的理解。这两个特性在 CNN 中分别体现为局部连接和权值共享,它们构成了 CNN 的归纳偏置。

- 局部连接:在 CNN 中,每个神经元并不是与前一层的所有神经元相连,而是只与前一层的一小部分神经元相连,这一小部分神经元构成了一个局部感受野。这种局部连接的方式使得 CNN 能够捕捉到图像中的局部特征,如边缘、角点等。

- 权值共享:在 CNN 中,同一层的所有神经元共享同一组权值,这意味着它们对输入数据执行的是相同的操作。这种权值共享的方式使得 CNN 具有平移不变性,即无论目标物体在图像中的位置如何变化,CNN 都能够识别出它。

对于围棋图片的识别,CNN 的这两个特性都发挥了关键作用。首先,局部连接使得 CNN 能够识别出棋盘上的单个棋子和棋子之间的关系。其次,权值共享使得 CNN 能够无论棋子在棋盘上的位置如何变化,都能够准确地识别出它。因此,CNN 能够有效地识别和理解围棋图片。

需要注意的是,虽然 CNN 具有平移不变性,但它并不具有旋转和缩放不变性。如果需要处理旋转和缩放变化,可能需要引入其他的技术,如数据增强或特殊的网络结构。

6. 系统一和系统二

在 人对视觉和语言信号的处理是毫秒级别的 里提到,Sutskever 一直都是坚信深度学习可以胜任人脑快速反应的任务(视觉,说话,对棋局的理解),这可以认为是在模拟大脑的系统一(直觉或者说下意识部分)。

(Yao et al., 2023) 则借用系统二的概念来模拟"慢思考", 也就是加入搜索回溯等试错的过程,三思而后行,而不是"脱口而出".

个人觉得系统一和二的划分是有很启发的,但系统一和系统二之间的界限在哪? 依照一般人脑的反映速度吗?还是根据人类感知和认知的划分? 另外对于人类来说需要进行"慢思考"的问题,适合于人工神经网络吗?比如普通人计算稍微复杂一点的数学都要用笔和纸逐步推导,但拉马努金却可以心算甚至凭直觉直接获得结果,因此多难的数学是需要"慢思考"?

7. 统计相关到因果

本节主要参考 JUDEA PEARL, AI, and CAUSALITY: WHAT ROLE DO STATISTICIANS PLAY? 同样这部分可以认为是对前文 两种统计模型之争 的继续讨论。

Judae pearl 在 chatgpt 出现前认为不可能从观察研究(observational studies)中回答因果或者反事实问题。 但 chatgpt/gpt4 出现让他承认自己忽视了训练数据集中文本所蕴含的因果信息。

读完后的感受是:

- 统计学或者因果推断可能都过于狭隘了, 他们使用的数据只是一个(抽象)符号以及该符号对应的一组数字。 然后希望从这些符号出发,通过相关性等 IID 假设下的统计关系去获得这些抽象符号概念层面的洞见。 这完全不符合人的(能感知到的)思维,并且适用范围很窄,比如给两张狗的图片,这是一个概念以及一堆像素值,统计学方法对此找到的最多是一些信号处理层面的局部的像素分布的相关性,最终这些数值问题还是被 DL 更好地 处理。

- 因果知识并不是从统计里归纳出来的,至少不是从这种狭隘的统计得到的,人们都是通过视觉,触觉,听觉等统计学难以处理的原始信号来得到某些概念之间的关系的(尤其还包括主动交互前后看到的关系,也就是对干预的直接参与),当前人类推理的因果模型是从这些感官交互的结果中得到并且在概念世界里迭代而稳定的,不是从一组数字,然后操作图的边来完成的。

- Judea pearl 认为 chatgpt 不是在走向通用 AI, 反而是阻止。然而 chatgpt 带动多模态(比如 gpt-4v)甚至动态环境交互,是更有可能走向通用 AI 的,这至少是一个在向前发展的方案,未来如果真的遇到无法解决的问题,可能会诉诸因果。可以认为这不是直接通向 AGI 的路,但应该比从因果出发更稳妥(至少在进步) 而在统计学上增补假设和概念的因果推断目前还几乎是一种特征工程模型,还是需要大量的人为总结的高层因果先验知识

- 但因果推断最终还是有意义,很多场景的数据就是带标签的数组:

- 一方面是因为人类已经深度参与改造世界了,世界不是纯粹原始信号,已经有非常多人类抽象概念的直接注入,很多人造物已经锁定好了概念以及围绕概念的数值信息,比如电压表的度数,当没有出现明显的事件(比如着火)而只有数值波动时,我们确实要从数值中去查找问题的原因,同时我们在设计之初就有一些定性的因果知识,这很适合因果图加观察性表格数据的因果推断形式。

- 另一方面人类数学发展几千年,有许多现成的处理数据的形式化手段。

对一些完全没有间接指示(语言描述)的未知事物的分析可能还是要用统计+因果推断方式。

神经网络本身的参数就是一组这样的未知的带标签数组,标签是通道或者层级,数组里是模型参数,因此对模型参数的分析很多时候会借助干预等因果分析手段。

8. 是否需要世界模型

世界模型是 Yann LeCun 一直倡导的,他在认为预测下一个状态的生成模型无法学习到真正的世界运作的机制, “好的”模型应该是根据世界模型去进行下一个状态的因果预测,它们不应该在表层数据上建模,而是在抽象表征空间下给定状态

Yann 对 causal prediction 的形式定义:

State of the world at time t: s(t) Imagined action taken at time t: a(t) Causal prediction: s(t+1) = g(s(t),a(t)) where g() is the world model. Such a causal world models enables planning.

There are other types, e.g. retrodiction: s(t-1) = g(s(t),a(t))

这个定义理论上当然没有问题,但问题是如何训练,比如假设 s(t) 是草原,a(t) 是闪电(尽管闪电可能不是动作),那么 s(t+1) 如果预测为雷声,就不是因果了,但训练的时候如何区分开闪电是否是动作,闪电背后的动作是什么? 是云相撞这种高层带有故事性地概念描述还是说云层电位差导致放电?

Yann 认为可以用观察数据自监督方式训练世界模型:

- You don't necessarily need RL to train a causal world model. You train it by observing (observation,action,next_observation) triplets. That's Self-Supervised Learning.

- The JEPA idea is that you learn two functions simultaneously : Enc() and Pred().

s(t) = Enc(x(t)) s(t+1) = Enc(x(t+1)) u(t+1) = Pred(s(t),a(t)) So that u(t+1) is a good prediction for s(t+1) and the encoder keeps as much information about x as possible. x is the input sequence, a is the proposed action sequence, s is the hidden state sequence, and u is the predicted state sequence.

- You can use the trained world model for planning, which infers a sequence of actions a that minimizes a given objective C(s).

So far, no need for RL. Only SSL from off-line observation data and planning. You would need RL to (1) adjust the world model as you go, (2) adjust the objective as you go, (3) train a policy that directly predicts an action without planning a(t)=p(s(t))

这里 Elias Bareinboim 的意思是:

- 除非数据中没有 confounding, 否则训练 SSL 训练出来的结果并非因果模型,参考闪电和雷声例子

没有一定的假设,无法从观察数据中学习到干预和反事实知识:

This comes in the form of a result called the Causal Hierarchy Theorem (CHT), as discussed on page 23 here: https://causalai.net/r60.pdf. This theorem represents a foundational impossibility shown in causal inference classes, which motivates the study of assumptions and the interplay between data and knowledge. The result can be thought of as demonstrating that learning the precise mechanisms is generally impossible.

总的来说,如今大模型是因为自监督数据相对容易获取,于是在数据量这个维度做到极端,以展示这种训练方式得到的模型的能力,这是一种经验性地大胆尝试。但 Yann 更多是站在某种假想的"理论"上,去否定这种方式的某个属性 – 比如无法理解物理世界机制。但似乎他对因果中的问题和真正从事因果推断群体又有偏差,比如他描述的以上训练方式,先用 enc 映射到抽象空间,然后在抽象空间获得准确地 s,a 和 s(t+1) 进行 SSL, 和 offline RL 几乎类似,但他不认为这是 RL, 也不认为这个模型不能处理 confounding 问题。

讨论归讨论,Yann 仍然一直在推动改进大模型,比如 Meta 的 LLaMA 。

参考 https://x.com/ylecun/status/1758740106955952191?s=20

Judea pearl 的观点则倾向于不一定要所谓的 "世界模型", 目前无法说清 LLM 是否学到了世界模型,也许世界模式只是人类脑容量不足因此要对世界规律进行更简洁的理论公式化压缩(从欧几里得、牛顿、爱因斯坦到 Kolmogorov)而使用的 trick,而大模型有足够大的参数量,不需要做这种理想化或理论化压缩,直接用大量参数编码规律,只做 theory-free prediction 。

参考:https://x.com/yudapearl/status/1758557230511903194?s=20

此外, 大语言模型真能“理解”语言吗? - 知乎 也提到,大模型引出了一种对 "理解" 的新的定义,可能不能因为它和人类所理解的 "理解" 不一样就否认它能够"理解",或许 LLM 能够从超越人类能够把握的相关性中看到因果关系,类似一种 "降维打击式" 的直觉。 但要科学地研究,需要新的测试智能和理解机制的基准和探测方法。

如果大语言模型和类似模型能以一种前所未有的规模利用统计相关性来工作,那么或许这也能被视为一种新的“理解”形式,一种能带来超人般预测能力的“理解”形式。正如 Deepmind 的 AlphaZero 和 AlphaFold 系统,它们分别在国际象棋和蛋白质结构预测的领域带来了如同“外星人”般的直觉

因此,可以提出这样的论点:近年来,人工智能领域已经创造出了具有新型理解模式的机器。

.

世界模型、系统一系统二、统计和因果问题关注的核心都是类似的。

9. 意识问题

这部分主要引用的是 {人类,今日,未来}简史的作者尤瓦尔赫拉利的观点,在简史系列书中,尤其是未来简史, 作者在最后写到:

如果把视野放大到整个生命,其他的问题或发展的重要性,都比不过以下三项彼此息息相关的发展: 1.科学正逐渐聚合于一个无所不包的教条,也就是认为所有生物都是算法,而生命则是进行数据处理。 2.智能正与意识脱钩。 3.无意识但具备高度智能的算法,可能很快就会比我们更了解我们自己。 这三项发展提出了三个关键问题,希望读者在读完本书之后,仍能常挂于心: 1.生物真的只是算法,而生命也真的只是数据处理吗? 2.智能和意识,究竟哪一个才更有价值? 3.等到无意识但具备高度智能的算法比我们更了解我们自己时,社会、政治和日常生活将会有什么变化?

在 2023 年的 The Politics of Consciousness | video lecture with Yuval Noah Harari - YouTube 视频中,尤瓦尔赫拉利更详细地谈论的意识,首先他认为:意识是承受痛苦(suffering)的能力。

意识的特点包括:

- 与政治、社会密切相关: 大部分科学研究对象都与政治保持距离,但意识研究的任何进展都会对社会政治施加影响力,因为它是法律法规、道德准则的制定的基石。例如堕胎合法性(婴儿什么时候有意识从而能感受到痛苦),各种特殊人群(自闭症,脑瘫等)的人权和政治权,动物福利等。正是由于石头,车没有意识,因此它们不是道德或政治主体,车被偷不是车感到痛苦,而是车主人。这是意识科学的特别之处。

意识并非客观中立,而是受到个人偏好和背景影响,与感觉或智力不同。

研究者在探究意识时,可能会采用由简单到复杂的分析思路,比如测试不同动物或人类对颜色、温度的感知能力, 然而感知能力和意识可能很不相同。意识发生在你感觉到了某些东西,但却宁愿去感觉其他事物的情况下。 我们会有条件地选择忽视某些客观事实而导向其他信息,因为事实违反了内心的某些偏好从而抗拒现实, 但无意识对象几乎不会抗拒现实,它只是在那里和一切进行交互。 再比如说有些人对痒不敏感,可能是因为感觉相关的神经元激活阈值较高,但他的意识能力却可以很强,一旦真正感觉到痒时,对此的反应也许比一般人还要大。同样,智力和意识也是非常不同的东西,智力是解决问题的能力,意识则是对感受的体验和反应。

总之,意识问题比较复杂,我还是比较认同"意识"可以和"智能"解耦的观点,可以出现没有意识但超级强大的 AI, 因此如果目标是提高 AI 能力,大部分情况下都不需要考虑意识问题。